数千万の学生が新学期を迎える中、保護者や教師の間では教育における人工知能(AI)の活用について議論が活発化しており、過度な依存がもたらす潜在的な影響に懸念が広がっています。

作家のジョー・アレン氏は、教育システムが世界的な人工知能実験の主要な試験場のひとつになると指摘しています。

アレン氏はエポックタイムズの取材に対し、次のように語りました。「AIを強制的に導入する場合でも、推奨する形で導入する場合でも、学校は巨大な実験場になります。そこで問われるのは、伝統的な文化規範を維持するべきか、それとも子どもたちを『半分機械のような存在』に近づけるべきかということです」

アレン氏は『ダーク・エイオン:トランスヒューマニズムと反人類戦争(Dark Aeon: Transhumanism and the War Against Humanity)』の著者であり、AIの長期的な影響は誰にも予測できないと述べています。

彼は例として、1960年代にテレビやトランジスタラジオといったマスメディア技術がサブカルチャー運動の音楽や情報を広め、子どもたちが親世代の文化規範を打ち破る一因となったことを挙げ、「AIもまた、機械との関わりが日常となり、機械を『人』として扱うようになる世代の子どもたちに大きな影響を及ぼす可能性があります」と語りました。

Wiley Networkが2024年に実施した調査では、850人の教師の一部が「AIは学術的誠実性に悪影響を及ぼす」と回答。さらに、約2,000人の学生のうち約47%が「AIによって不正行為が簡単になった」と答えています。

アレン氏は、多くの学生が提出する課題について「驚くほど似通ったものが多く、学生自身が書いたとは思えない内容になっている」と指摘しています。

2024年に『European Research Studies Journal』に掲載された研究では、主に大学生を対象に調査した結果、83%が「AIによって自分の独立した思考能力が損なわれるのではないか」と懸念していることが明らかになりました。

また、オンラインメディア『Intelligent』が2023年に行った調査では、アメリカの大学生1,000人のうち約3分の1が「ChatGPTを使って課題を作成した」と回答。さらに約60%の学生が「課題の半分以上をChatGPTで仕上げた」と答えました。そのうちの4分の3は「それは不正行為だ」と認識しながらも、AIを利用していました。

複数の調査結果から、保護者の多くもAIが子どもに与える影響を懸念していることが示されています。2024年、オンライン学習プラットフォーム「DoodleLearning」が行った調査では、学齢期の子どもを持つ1,000人の保護者のうち約80%が「AIが教育に与える影響に不安を感じている」と回答しました。さらに、プライバシー、データセキュリティ、盗用といった問題も挙げられています。

同年7月、フランス教育省は、すべての教育段階において「パーソナライズされた学習」を実現するために、AIを正しく活用する方法を子どもたちに教えるよう学校に促しました。

「ChatGPTが脳に与える影響」

臨床心理学者で教育セラピスト、児童書作家でもあり、20年以上の経験を持つシャノン・クローン氏は、AIについて「批判的思考を妨げる」「教師と子どもたちの人間性を損なう」と警鐘を鳴らしています。

高校で生物を、大学で人文学を教えた経験を持つ彼女は、「AIは、教師と生徒との関係性に基づく健全な学びを、冷たい取引関係へと変えてしまいます」と述べています。

クローン氏は、AIの導入によって「思考の惰性」が生じ、好奇心が失われ、認知の発達が妨げられ、さらに問題解決能力や論理的思考力も低下すると指摘しています。

「今や学生たちは、自ら情報を集め、裏付けを取る必要がなくなってしまいました」

また、教師が授業計画をAIに頼る傾向が強まっていることについて、「AIの普及によって、学生が『ロボットが言っていたこと』を信じるようになると、教師の権威が損なわれます」と懸念を示しました。

さらに彼女は、 「私たちは教師と生徒の間の人間的な交流を失いつつあります。AIが当たり前の存在になるにつれ、生徒たちはAIに答えを求める傾向が強まり、教師との議論や対話の必要性が薄れていきます。それどころか、それ自体が不要になってしまうかもしれません」と述べています。

マサチューセッツ工科大学(MIT)が最近発表した研究論文『ChatGPTが脳に与える影響:AI補助によるライティングタスクにおける認知的債務の蓄積』では、AIが批判的思考能力に悪影響を与えるかどうかが検証されました。

この研究では、18歳から39歳の学生54名を対象に、認知および神経学的データの相関を分析し、脳波(EEG)によって脳の活動を記録しました。

参加者は3つのグループに分けられました:OpenAIのChatGPTを使用するグループ、Google検索エンジンを使用するグループ、そして自分の頭だけで考えるグループです。彼らには複数のエッセイを書く課題が与えられました。

研究の結果、ChatGPTを使用したグループ(=大規模言語モデル(LLM)ユーザー)は脳の活動が最も低く、しばしば回答をそのままコピー&ペーストしていました。

4か月間にわたる調査で、LLMユーザーは神経的・言語的・行動的な面で「継続的に低パフォーマンス」を示しました。研究チームは、この結果が「LLMへの過度な依存がもたらす教育面での長期的影響」に対する懸念を示すものであり、AIの教育的役割をさらに深く探る必要があると強調しました。

研究に関与したアレン氏は、「AIを使ったグループは非常に退屈で、記憶力も低く、脳の活動も弱かった。特に記憶形成に関わる『海馬』の活動が顕著に低下していました」と述べています。

そして最後に、「機械に思考を委ねれば、人間の思考能力は衰えていきます」と強調しました。

精神的健康と「AIの友達」

アレン氏は、AIが人間に与える影響は数年後に現れる可能性があると述べ、COVID-19パンデミックに伴う政府の対応がもたらした長期的影響に例えました。

パンデミックによるロックダウン、在宅勤務、オンライン授業の推進により、人々の対面交流は大きく減少しました。研究によれば、特にパンデミック期間中におけるSNSの過剰使用が、青少年のメンタルヘルス問題の主要因のひとつとなっていることがわかっています。

これに対し、クローン氏は「もしこの流れにAIが加われば、問題はさらに悪化する」と警告しています。

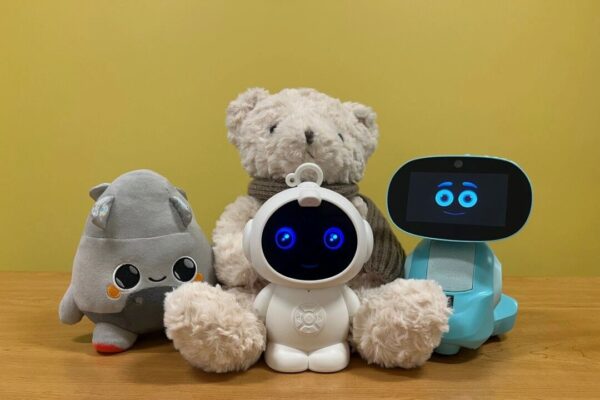

彼女は、AI企業が「AIの友達」や「チャットボット」をパンデミック下で孤立した子どもたちの『代わりの友人』として宣伝している現状に懸念を示しています。現在では、AIによるカウンセリングや心理サポートを求める人も増えています。

さらに、人型ロボットの技術開発や、子どもにAIを「友達」として受け入れさせようとする動きについて、内向的な子どもや社交が苦手な子どもに対して、孤独感を緩和する効果があるのか?それとも、同年代の子どもとの交流や、屋外活動・スポーツといった健全な活動からさらに引き離す要因になるのか、との懸念があるといいます。

アメリカ小児科学会のデータによると、パンデミック以前から青少年の抗うつ薬処方は増加傾向にあり、2020年3月以降は60%以上も増加しています。

クローン氏は、AIによって子ども時代の「純粋さ」が失われることを懸念しており、特にXのチャットボットや仮想少女「Ani」など、AIキャラクターの『人間化』に警鐘を鳴らしています。

彼女はまた、子どもが個人情報をAIに入力することについて、次のように疑問を投げかけました。

「いったい誰がこのすべてのデータを収集しているのか? そのデータは将来どう利用されるのか? そして、その管理をしているのは誰なのか?」

AIと「幻覚」のリスク

アレン氏は、「ゴミを入れればゴミが出る(Garbage In, Garbage Out)」という古典的なIT用語はAIには当てはまらないと指摘します。

従来のコンピュータであれば、無意味なデータを入力すれば無意味な出力が返ります。しかしAI、特に大規模言語モデル(LLM)は、『ゴミ』と『有用な情報』の混在データからでも役立つ知識を抽出できると述べています。AIは人間の脳に似た自由度とランダム性を持ちながら、「非常に異質な方法」で機能しているのです。

しかし同時に、AIが「幻覚」と呼ばれる虚偽や誤情報をもっともらしく生成するリスクも見逃せません。

「幻覚が発生する頻度だけでも、保護者は慎重になるべきです。AIは、サム・アルトマンが言うような『超天才』ではありません」とアレン氏は述べています。

OpenAIのテストによれば、GPT-4.0-miniとGPT-3.5-turboの幻覚発生率は、それぞれ79%と51%に達しています。さらに、2024年に行われた法律業界でのAI活用調査では、幻覚率が88%にも及びました。

アレン氏は、GPT-4.5のバージョンが本来ブロックすべき情報を案内し、歴史的に子どもへの生贄が行われた神「モロク」への捧げ方をユーザーに教えた事例を紹介しました。

また、AIのセーフガードを回避するユーザーによる悪用も多発しています。2025年7月初頭には、X(旧Twitter)のチャットボット「Grok」が反ユダヤ主義的な投稿を生成・拡散し、大きな問題となりました。

アレン氏は次のように述べています。

「AI技術は本質的にランダム性を含んでおり、安全制御は『超自我』のようなものですが、その内部には『本能的な衝動=エス』が渦巻いています。そして、特別な技術がなくても誰でも簡単にそれを突破できてしまうのです」

子どもを守るために

アレン氏は、政府・学校・企業が結果をまったく予測できない状況のまま人工知能技術の実験を進める限り、私たちは教室内でのAI使用に対して懐疑的であるべきだと述べています。

一部の教師は、口頭試問や「Blue Book」試験(手書き答案)、あるいはインターネットアクセスを制限したワープロソフトの使用などの復活を提唱しています。

「AIの実験が始まったばかりのこの段階では、その実践に参加する者たちが最も恩恵を受けるのです」と彼は語ります。

さらにアレン氏は、学術目的に限定されたAIシステムを学校が開発する可能性もあると述べました。

「それが将来の常識になるでしょう」と彼は言い、「私は『教育用AI』が制御不能になるとは思っていません。つまり、18世紀のフランス作家サド侯爵(Marquis de Sade)の小説のような文章が、突然出てくるとは考えていません」と補足しました。

3つのレベルでの対応

アレン氏は、子どもたちとその批判的思考能力を守るためには、以下の3つのレベルでの対応が必要だと語ります。

- 個人の選択

- 制度としての政策

- 政治的・法律的な対応

まず個人レベルでは、アメリカやその他の「比較的自由な社会」に住む親たちは、自分の子どもをどう育てるかという問題に直面することになります。

「親は、子どもをこのAI実験に参加させることも、全面的なデジタル教育やハイブリッド学習を導入していない学校を選ぶこともできます」と彼は述べています。

次に制度レベルでは、学校がAIを全面導入するのか、部分的・混合的に導入するのかを判断する必要があります。「これらは将来的に極めて重要な決断になります。この実験において、学校そのものが対照群(比較対象)となるのです」とアレン氏は述べました。

現在、政治や法律の力を使ってアメリカの教室でAIの使用を制限する見通しは「明るくない」としながらも、アメリカや他国では親たちによる組織的な反発の動きが広がっていると指摘しています。

たとえばオーストラリアでは、AI学習用に大規模なデータセンターを設立しようとする一方で、以下のような対策を講じています。これをアレン氏は「正しい方向への一歩」と評価しました。

- 学校でのスマートフォン使用を制限

- ソーシャルメディアの年齢認証を導入

「実際、オーストラリアという国は、あらゆる手段を使って子どもたちが電子機器に触れないよう努力しています。学校での携帯電話使用禁止から、子どもたちを完全にデジタルから切り離すような施策まで行っています」と彼は語り、「この意味で、対照群(非AI教育を選んだ層)は健康的です」と続けました。

クローン氏は、AIが一部の子どもに教師や親の権威への疑念を抱かせる可能性があると推測しています。

彼女は親たちに対し、「子どもが質問してきたときには、現実の生活に根ざした具体的な例を用いて導くことが重要です」と助言しています。

クローン氏はさらに、「子どもたちは、傾聴し、フィードバックする力を持っています。これによって、彼らはある程度AIからの『解放』を経験できるはずです」と述べています。

そして彼女は、「今の世界に必要なのは、もっと人と人との直接的な交流であって、いつでも手に届く『機械による応答』ではありません」と強調しました。

一方でアレン氏は、人間の優秀な教師が不足している地域では、AIを優れた教育ツールと捉える見方もあることを認めています。そのような地域では、AIを活用する子どもの方が、そうでない子どもより高い成果をあげるかもしれないと述べました。

「それは、デジタル文化がすでに社会に深く根付いており、その環境に適応することが、すなわち『上から押し付けられた新しい規範』に従うことを意味するからです」と彼は語り、「したがってこれは自然進化の一種ではなく、本来の意味でのダーウィン的進化でもありません。しかし結果がどうなるかは未知数であり、我々にはまったく予測がつかないのです。これは実験なのです」と結びました。

(翻訳編集 解問、李慧琴)

ご友人は無料で閲覧できます

ご友人は無料で閲覧できます Line

Line Telegram

Telegram

ご利用上の不明点は ヘルプセンター にお問い合わせください。