中国のテック企業がChatGPTに対応する形でチャットボットを発表するなか、専門家は中国のAI事情が多くの脅威をもたらすと警告している。

2023年8月31日、テック大手の百度(バイドゥ)がChatGPTの中国版とされる「文心一言(アーニー・ボット)」を発表し、同年9月13日にはアリババが自社のAIモデル「通義千問」を発表した。

ERNIE(アーニー)は2024年3月に初披露されたものの、現在は政府の承認を経てダウンロード可能になっている 。

百度はERNIEのリリース発表で、「文心一言に加えて、百度は理解・生成・推論・記憶という生成AIの4つの中核能力をユーザーが十分体験できる一連のAIネイティブアプリをリリースする」と述べている(発表文より)

米国国内で戦略的競争が激化する中、北京はAI技術に取り組む中国企業への支援を強化している。アリババのクラウド事業部門はWeChat上の文面で、OPPO、タオバオ、ディン・トーク、浙江大学など複数の組織が「通義千問」を使った大規模言語モデル(LLM)の社内トレーニングでアリババと協力契約を結んだと伝えている。

専門家は、中国が最先端AIツールを運用することで敵対国に対して国家安全保障上のリスクが高まる可能性があると指摘している。

AI研究者であり著作「Artificial Intelligence Methods for Optimization of the Software Testing Process: With Practical Examples and Exercises(ソフトウェアテストプロセスの最適化のための人工知能手法:実例と演習付き)」共著者のサハル・タヴィリ氏は、「ChatGPTやアリババの通義千問のような大規模言語モデルや同様のAIシステムを利用することは、誤情報、自動攻撃、倫理的懸念、データプライバシーの問題を引き起こし得るため、セキュリティ上の脅威と見なされる可能性がある」と述べている。

生成AIとは、音声・コード・画像・テキスト・シミュレーション・映像など、新たなコンテンツを生成できるアルゴリズムを指す。大規模言語モデル(LLM)はその生成AIのうち、テキスト出力能力を担うコンポーネントに当たる。

LLMは、テキストやその他のコンテンツを認識、翻訳、予測、生成するなど、多様な言語処理タスクを実行できるディープラーニングアルゴリズムを用いる。

英国を拠点とするディープテック投資家のアシュウィン・クマラスワミ氏は、中国は複雑なAI LLMの活用において世界の他地域より15年先行していると見積もっている。クマラスワミ氏は複数のテクノロジー企業の取締役を務めている。

中国では大半の欧米系ソーシャルメディアが禁止されているものの、同氏は中国で「微信」として知られるテンセントの「WeChat」プラットフォームが、中国国内で広く普及し、買い物、メッセージ送受信、ビジネス取引、ミニブログ、チャットボット機能など多様なサービスを提供している点を指摘した。

「デジタル面で彼らは非常に強く、かつ統合されている」と、同ベンチャーキャピタリストはエポック・タイムズの取材に語った。

核心的な社会主義の価値観「別の話をしよう」

専門家らは、中国からのAI関連の脅威は、北京と西側諸国との間のイデオロギー的な隔たりに起因すると指摘する。

ホノルル拠点のシンクタンク「パシフィック・フォーラム」でサイバーセキュリティおよび重要技術部門のディレクターを務めるマーク・ブライアン・マナンタン氏は、エポックタイムズの電子メール取材に対し、「中国がLLMブームにどのように取り組んでいるかを評価するには、国家インターネット情報弁公室が打ち出した規制を分析する必要がある」と述べた。

同氏はさらに、「世間の関心はAIに集中しているが、中国にとっての主要な懸念は依然として情報セキュリティにあり、それは核心的社会主義価値観に根ざし、かつデータセキュリティや個人情報保護に関する既存の法律・政策と一致している」と説明した。

タヴィリ氏は、中国版ChatGPTを含むAIモデルは「ブラックボックスシステム」であると指摘する。これは「モデルの内部構造や意思決定のプロセスが人間にとって容易に解釈・理解できない」という意味だ。

生成AIが持つブラックボックス的性質は、しばしば予測不能で、自律的な思考プロセスのように見えるかもしれない。このため、他国は中国のAIが持つイデオロギー的動機を見抜けない可能性があると同氏は警告する。

しかし、報道によれば、中国のハイテク企業はあらゆる段階で政権への報告が義務付けられており、このことが北京のLLMを巻き込んだ戦略的推進を疑う余地のないものにしていると専門家は指摘している。

事実上、BBC(英国放送協会)が2023年9月9日に報じたところによれば、文心一言に「難しい」質問をすると、「別の話をしよう」や「申し訳ありません。この質問にどう答えるべきかまだ分かりません」といった返答をするのが一般的だという。

クマラスワミ氏は、中国国民はほぼ完全に中国共産党の政治イデオロギーに対する抵抗を諦めており、長年にわたって洗脳されてきたと述べる。

「一般的な世論や日常会話に関するデータや情報がある以上、それらはChatGPT型の仕組みで自動補完として利用できる。しかし中国はイデオロギーを広めるのにAIを必要としていない。学校教育を通じて若年層の思考形成を厳格に管理しているからだ」と同氏は語った。

軍事利用

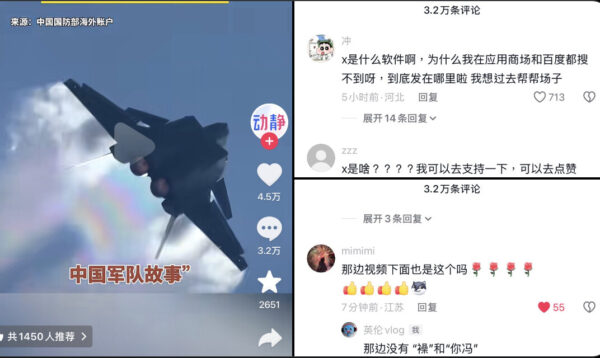

中国のLLMは、特に認知戦や情報戦といった分野で、中国人民解放軍(PLA)における応用の可能性を持つ。

米空軍大学の中国航空宇宙研究所アナリスト、ジョシュア・D・ボーマン氏は、8月21日に発表した論文「中国のChatGPT戦争」の中で、生成AIはフリードリヒ・エンゲルスの言葉を借りれば「戦争に変化、あるいは革命をもたらす」と記している。

同氏は、中国人民解放軍がAIの軍事応用を最大限活用しようとしていると述べ、最近の数か月間に中国の軍事専門誌でAIに関する論文が大量に発表されている事実を指摘した。

ボーマン氏は、現在中国国防大学の教授を務める中共軍の胡暁峰少将(退役)が執筆した記事を引用し、胡少将は「ChatGPTに代表される人工知能の最先端技術は、必然的に軍事分野に応用されるだろう」と述べた。

タヴィリ氏によれば、大規模言語モデル(LLM)や自然言語処理(NLP)モデルには、軍事・防衛分野で複数の応用可能性があるという。ボーマン氏の論文では、応用の主な分野として以下の7項目が挙げられている。

「人間と機械の相互作用、意思決定、ネットワーク戦争、認知領域、兵站、宇宙領域、訓練」

パシフィック・フォーラムのマナンタン氏は、認知戦や情報戦の側面について言及し、「ChatGPTは偽情報キャンペーンを拡大し、その実行能力を高め得る」と指摘した。

「LLMはより説得力のある文章を作成できる。その他の安全保障上の脅威としては、マルウェア生成によるハッキングや高度なフィッシング攻撃がある」

一般的に認知戦とは、敵対者の認識、信念、意思決定に影響を与える行為を指す。

タヴィリ氏によれば、「この点において、AIは戦略的計画や情報分析、翻訳に活用できる。さらにAIモデルは軍事訓練プログラムやシミュレーション環境に組み込むことで、現実的かつ双方向的なシナリオを提供できる」という。

落とし穴への警戒

ボーマン氏は、PLAメディアがChatGPTの戦争利用は不可避だと論じる一方で、「近い将来、軍事作戦に大規模に組み込むような動きは急がれていない」とも述べる。その背景には、「データセット構築、最適化、技術への相互不信」という3つの主要な懸念があると指摘した。

さらに検閲の問題もある。「PLAメディアは言及していないが、中共自身の問題もある。党に否定的な発言をする可能性のあるプログラムは許可されないため、生成AIの総合的な有効性を阻害する可能性がある」という。

総じてボーマン氏は、「中国は戦場における生成AIで先行者(またはそれに近い立場)となる必要性を理解している」と述べる。

ただし、米国と同様、中国も知能化戦の多くの潜在的な落とし穴を認識しており、技術の導入を急ぎすぎないよう慎重な姿勢を保っていると見ている。

ご友人は無料で閲覧できます

ご友人は無料で閲覧できます Line

Line Telegram

Telegram

ご利用上の不明点は ヘルプセンター にお問い合わせください。